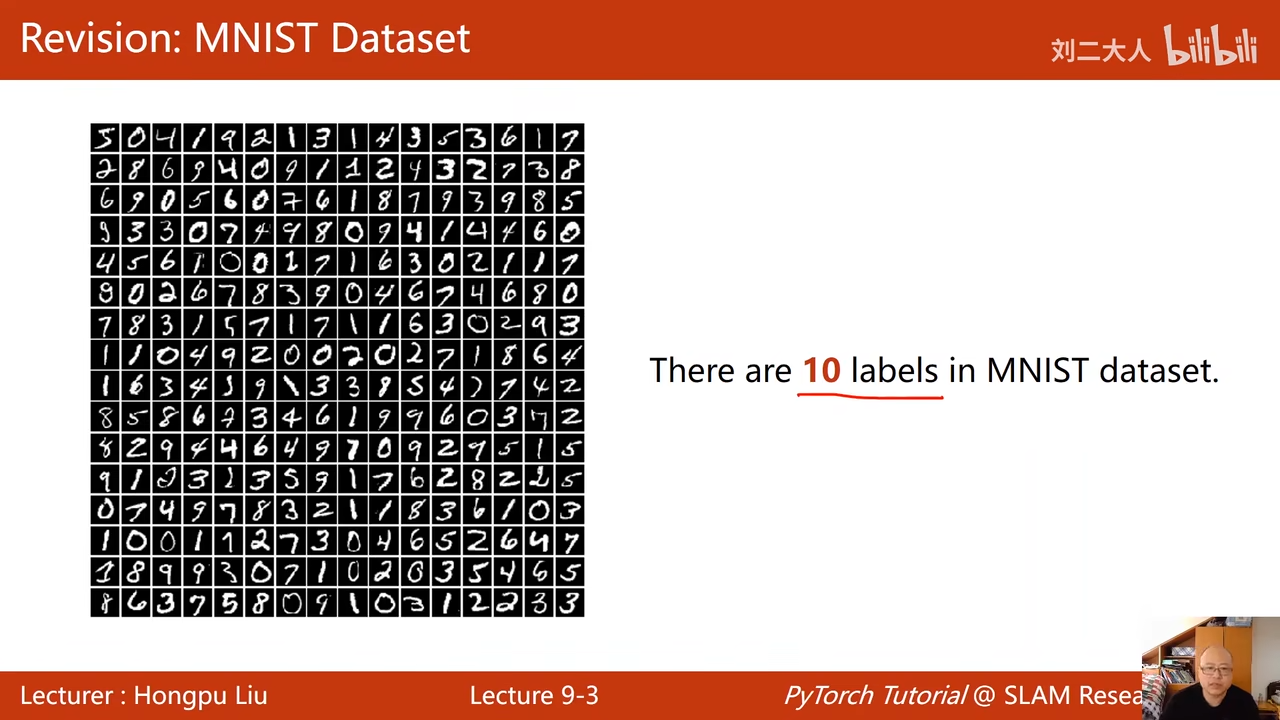

9多分类问题

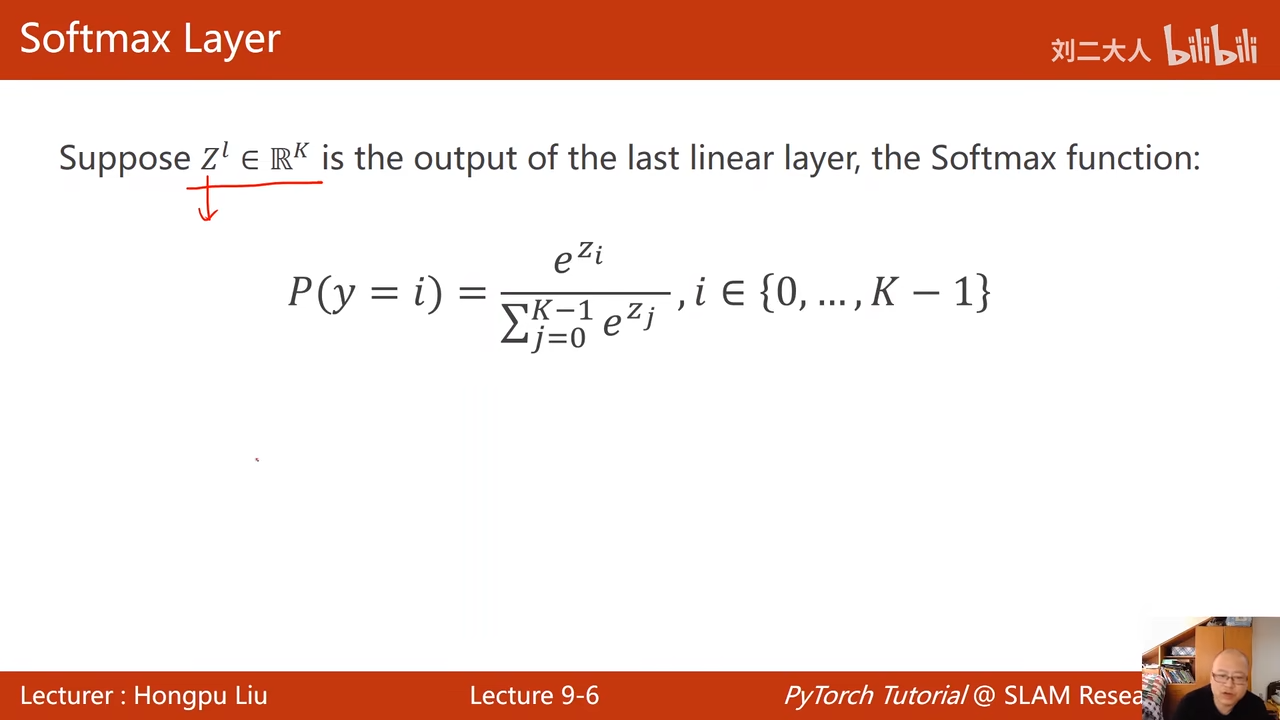

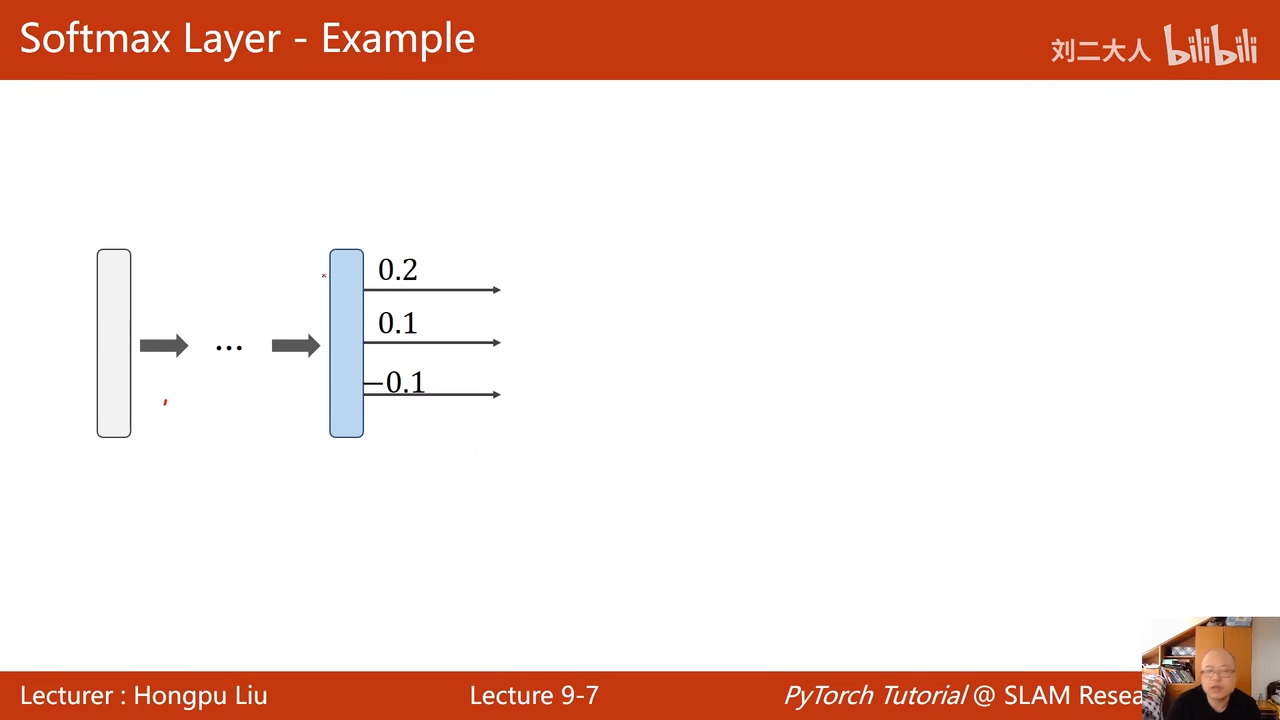

使用softmax 00:01:46.755 00:01:58.457

十个分类神经网络应该如何设计

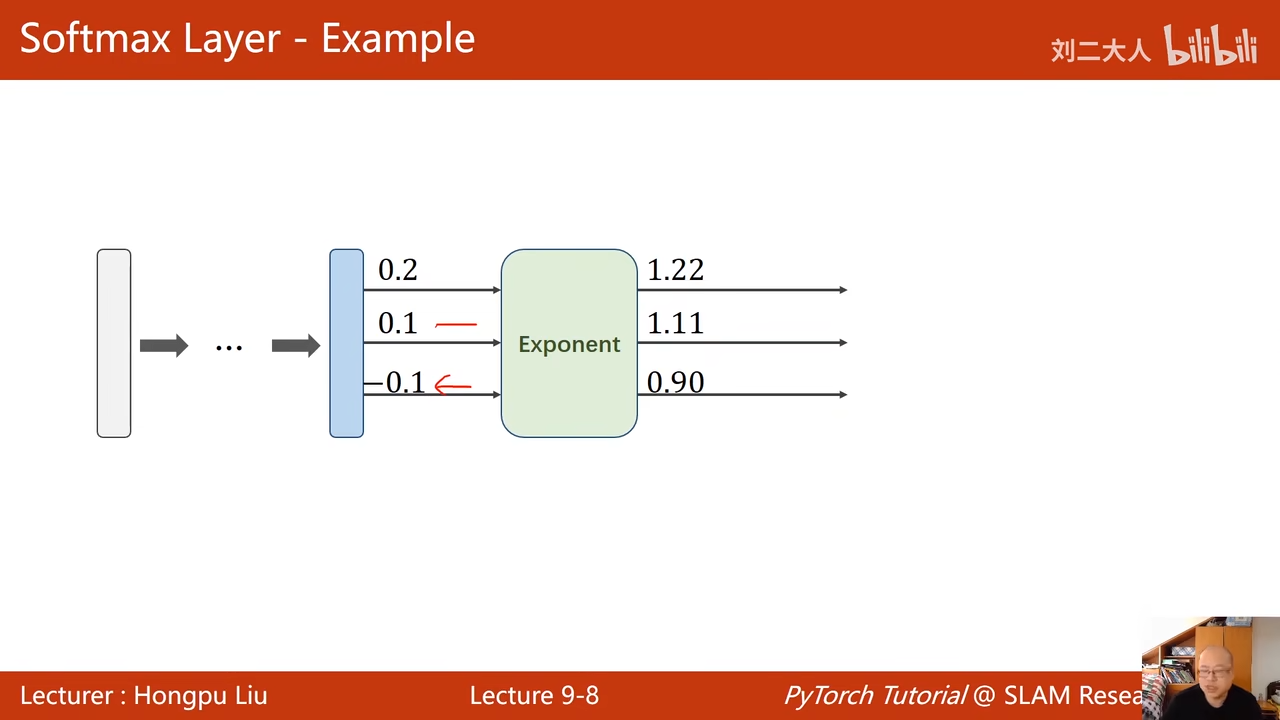

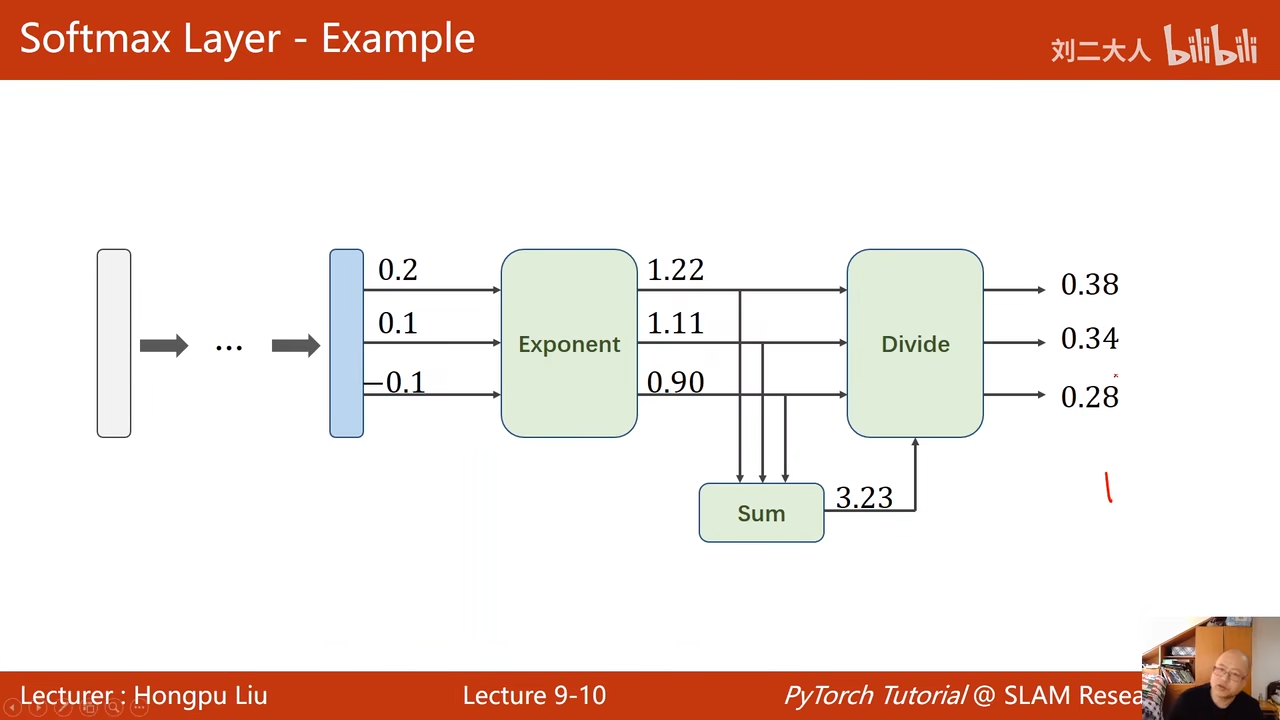

00:03:21.365  希望的要求: 输出之间竞争性 输出就是一个分布 1. 概率大于0 2. 概率求和为1 00:08:00.963

希望的要求: 输出之间竞争性 输出就是一个分布 1. 概率大于0 2. 概率求和为1 00:08:00.963

求和之后结果为100:12:58.619

最后一层是不需要手动进行非线性激活的,因为交叉熵损失会直接激活

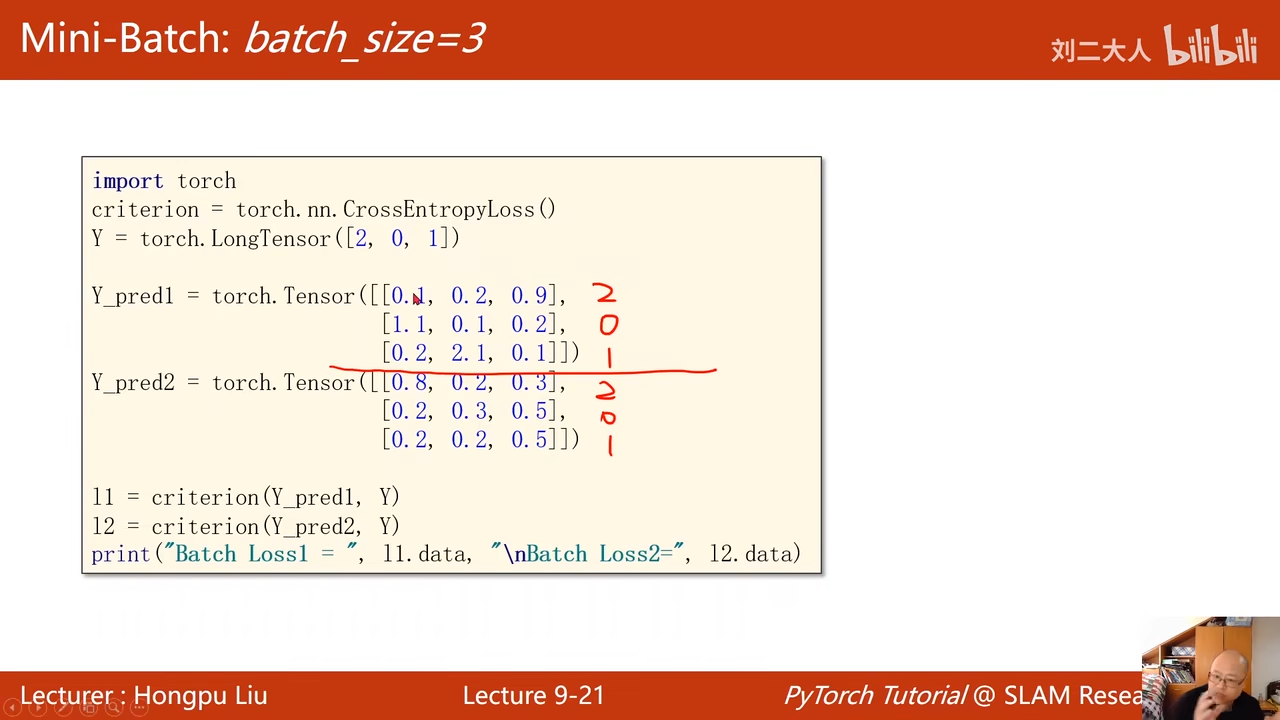

00:24:38.539  00:24:21.657

00:24:21.657  2表示这个第二个元素最大 0表示第0个元素最大 1表示第一个元素最大

2表示这个第二个元素最大 0表示第0个元素最大 1表示第一个元素最大

y_pred和预测的比较拟合,所以第一个预测算出来的损失会比较小 00:26:14.653

00:26:40.399  思考交叉熵和nll损失的区别

思考交叉熵和nll损失的区别

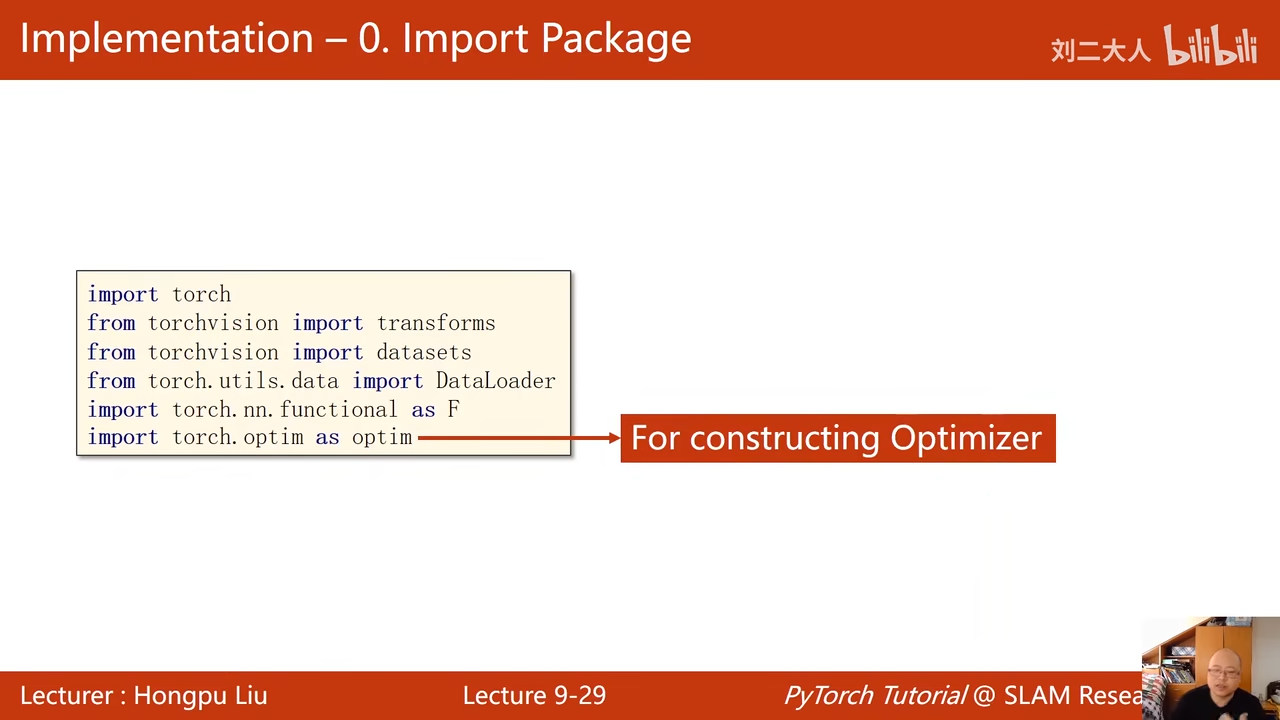

00:29:06.551  这里我们要引入测试的功能

这里我们要引入测试的功能

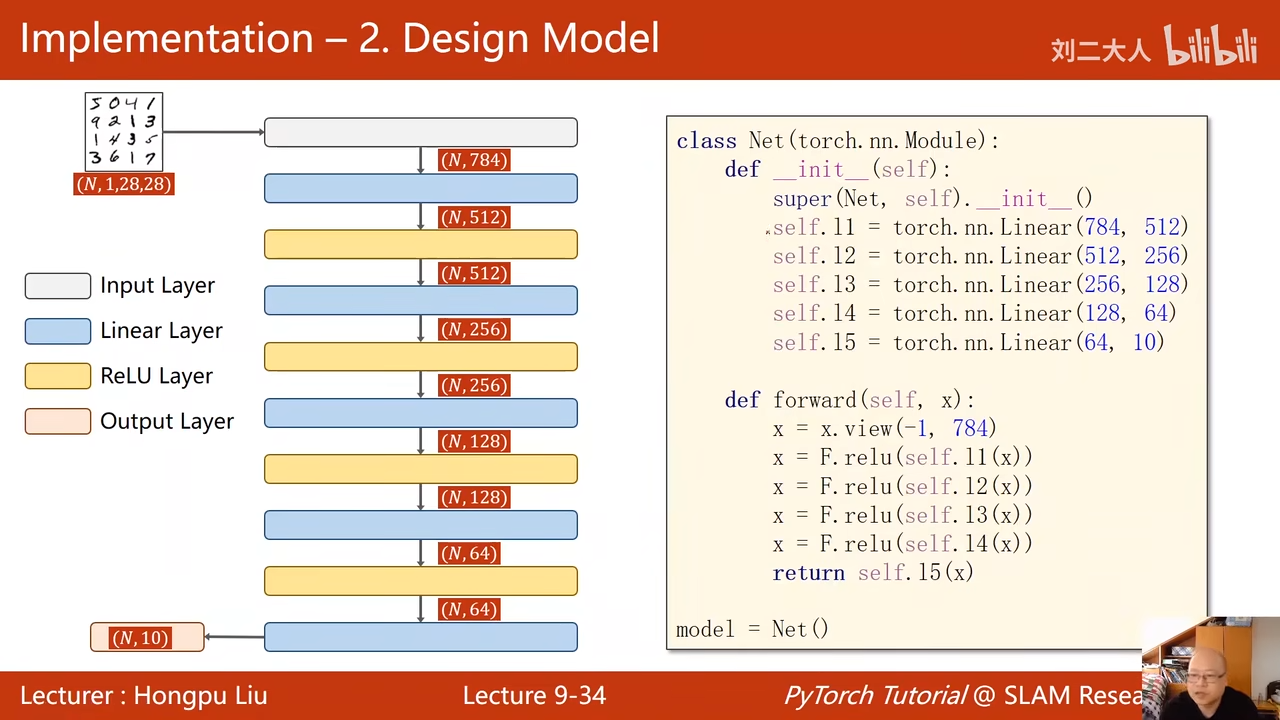

代码实现: 00:29:52.698  不适用sigmod了,改用relu 00:30:08.431

不适用sigmod了,改用relu 00:30:08.431  00:30:14.345

00:30:14.345

优化器 00:30:23.356

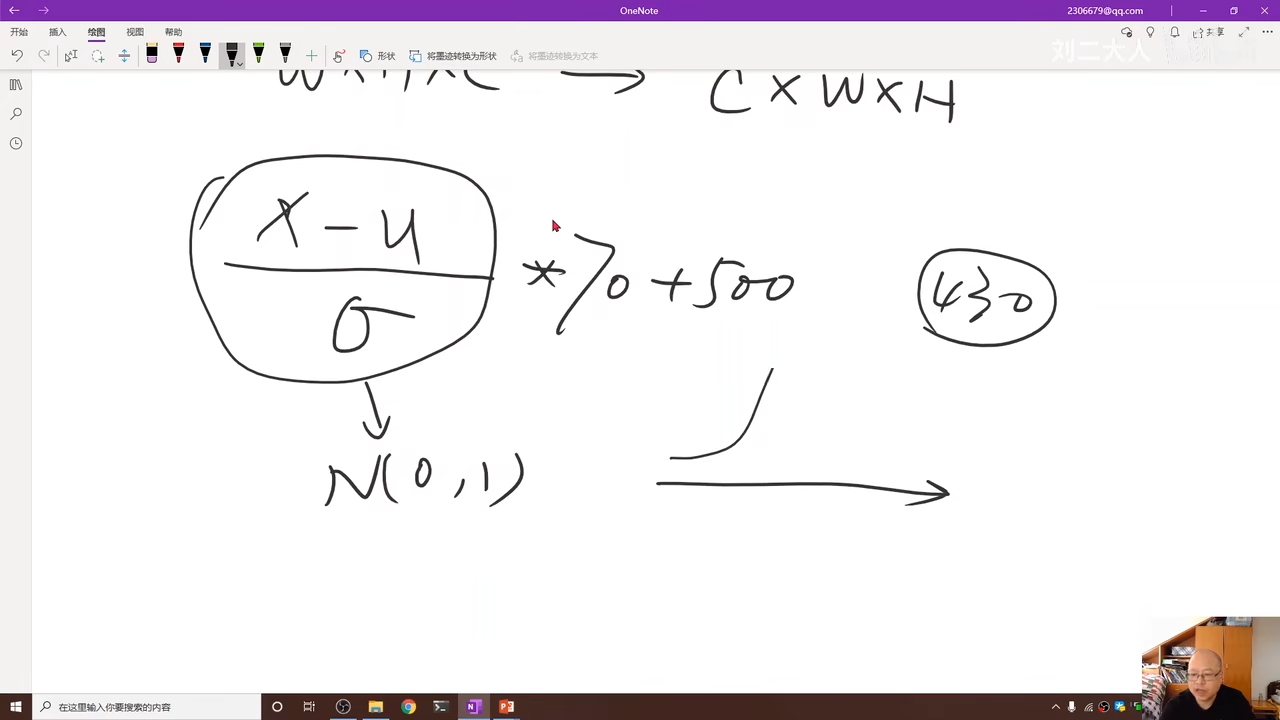

这里最主要的区别,就是把图像转换成图像张量

单色就是单通道,多色就是多通道 一般是三通道 00:33:41.502

opencv中常获取的图像信息:w * H * c 但是在pytorch中需要把c放到最前面 00:33:57.790

00:34:16.453  通道、、宽 、、高 利用transforms的totesonor实现从pil ->pytorch

通道、、宽 、、高 利用transforms的totesonor实现从pil ->pytorch

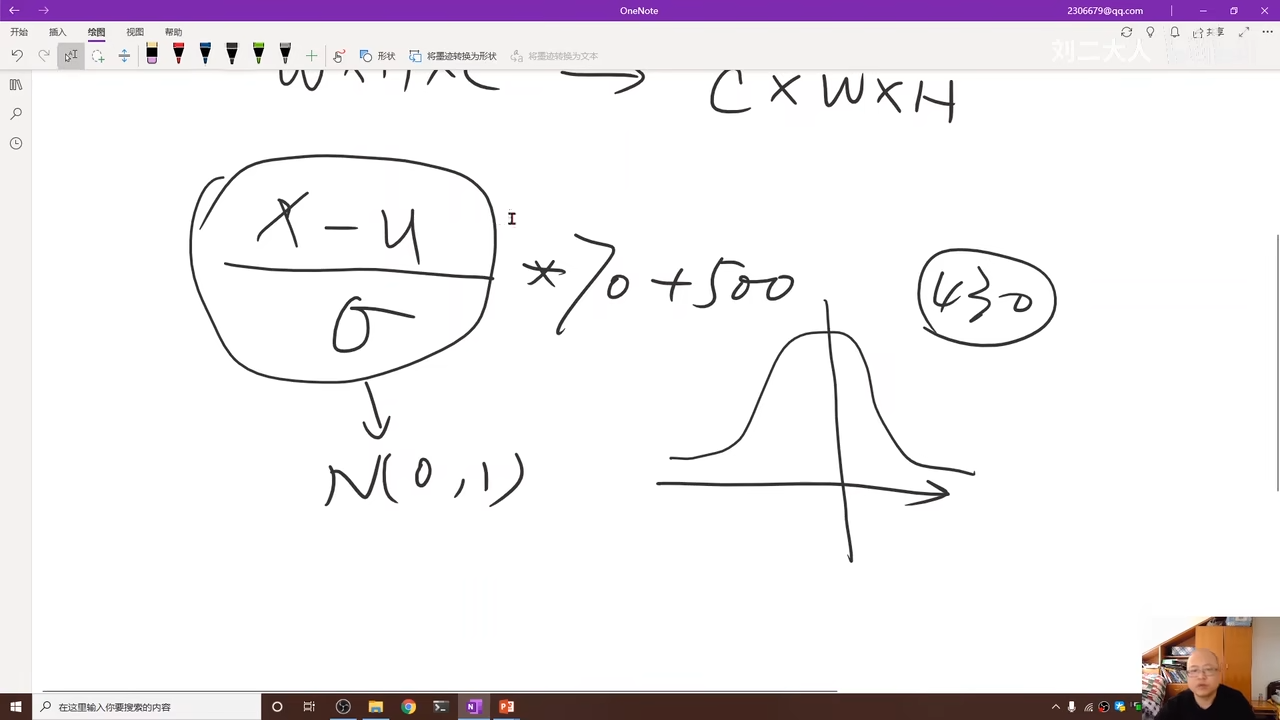

normailize 00:36:35.981

normal就是为了将数据转换成(0,1) normalize第一个是μ 第二个参数是 σ

全连接神经网络需要时右边的列表

00:40:38.006  784表示列数 -1表示 00:42:32.533

784表示列数 -1表示 00:42:32.533

00:45:23.376  enumerate是为了能够获取当前训练的轮数) 00:48:45.600

enumerate是为了能够获取当前训练的轮数) 00:48:45.600

==测试== 00:48:56.960  不需要进行梯度 这里使用with torch.no_grad()就可以实现这个作用域内的代码不会进行梯度计算

不需要进行梯度 这里使用with torch.no_grad()就可以实现这个作用域内的代码不会进行梯度计算

dim表示维度,这里表示一行 00:48:06.376

00:48:59.390

1

total+=labels.size(0)

将推测出来的分类也就是predicted跟labels作比较 如果为真就是1,假就为0

将正确的数量除以总数量

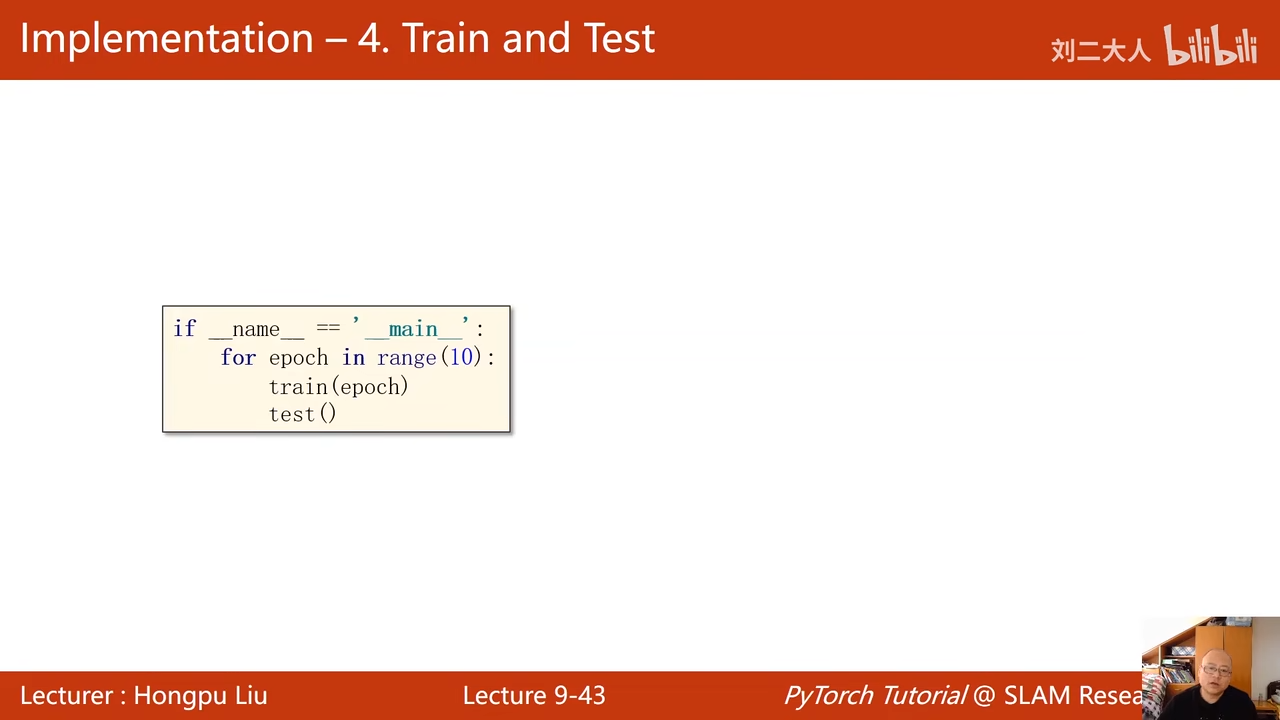

一轮训练一轮测试 00:50:12.320

注释是每十轮进行一次测试

这样的全连接00:52:23.768 00:52:49.617

00:53:14.233 自动特征提取 cnn

自动特征提取 cnn

手动特征提取fft、小波

总结

softmax 和交叉熵损失

交叉熵

交叉熵